BTC/HKD+0.49%

BTC/HKD+0.49% ETH/HKD+0.91%

ETH/HKD+0.91% LTC/HKD+2.05%

LTC/HKD+2.05% ADA/HKD-1.45%

ADA/HKD-1.45% SOL/HKD+3.08%

SOL/HKD+3.08% XRP/HKD-0.7%

XRP/HKD-0.7%來源:機器之心

純文本大模型方興未艾,多模態領域也開始涌現出多模態大模型工作,地表最強的GPT-4具備讀圖的多模態能力,但是遲遲未向公眾開放體驗,于是乎研究社區開始在這個方向上發力研究并開源。MiniGPT-4和LLaVA問世不久,阿里達摩院便推出mPLUG-Owl,一個基于模塊化實現的多模態大模型。

今天要介紹的是mPLUG-Owl,該工作不僅通過大量cases展示出優秀的多模態能力,還第一次針對視覺相關的指令理解提出一個全?的測試集OwlEval,通過人工評測對比了已有模型,包括LLaVA、MiniGPT-4、BLIP-2以及系統類MM-REACT等工作,實驗結果表明mPLUG-Owl展示出更優的多模態能力,尤其在多模態指令理解能力、多輪對話能力、知識推理能力等方?表現突出

Azuki:更新Elementals背景元數據的投票將于7月8日開啟:7月7日消息,NFT項目Azuki發推稱,有關更新Elementals背景元數據的投票將于太平洋時間7月7日15:00左右(北京時間7月8日06:00)開始。Azuki表示,藝術團隊提出了一個細微的域背景(domainbackground),并帶有輕微的色偏偏移,以應對潛在的變化。即使投票結果導致Elementals系列中的背景元數據沒有變化,域背景仍將可用于收藏家Profile中的鏈下裝備。[2023/7/7 22:23:11]

論文鏈接:https://arxiv.org/abs/2304.14178

代碼鏈接:https://github.com/X-PLUG/mPLUG-Owl

今日恐慌與貪婪指數為54,等級仍為貪婪:金色財經報道,今日恐慌與貪婪指數為64(昨日為60),貪婪程度較昨日有所上升,等級仍為貪婪。

注:恐慌指數閾值為0-100,包含指標:波動性(25%)+市場交易量(25%)+社交媒體熱度(15%)+市場調查(15%)+比特幣在整個市場中的比例(10%)+谷歌熱詞分析(10%)。[2023/5/7 14:48:10]

ModelScope體驗地址:

https://modelscope.cn/studios/damo/mPLUG-Owl/summary

HuggingFace體驗地址:

https://huggingface.co/spaces/MAGAer13/mPLUG-Owl

多模態能力展示

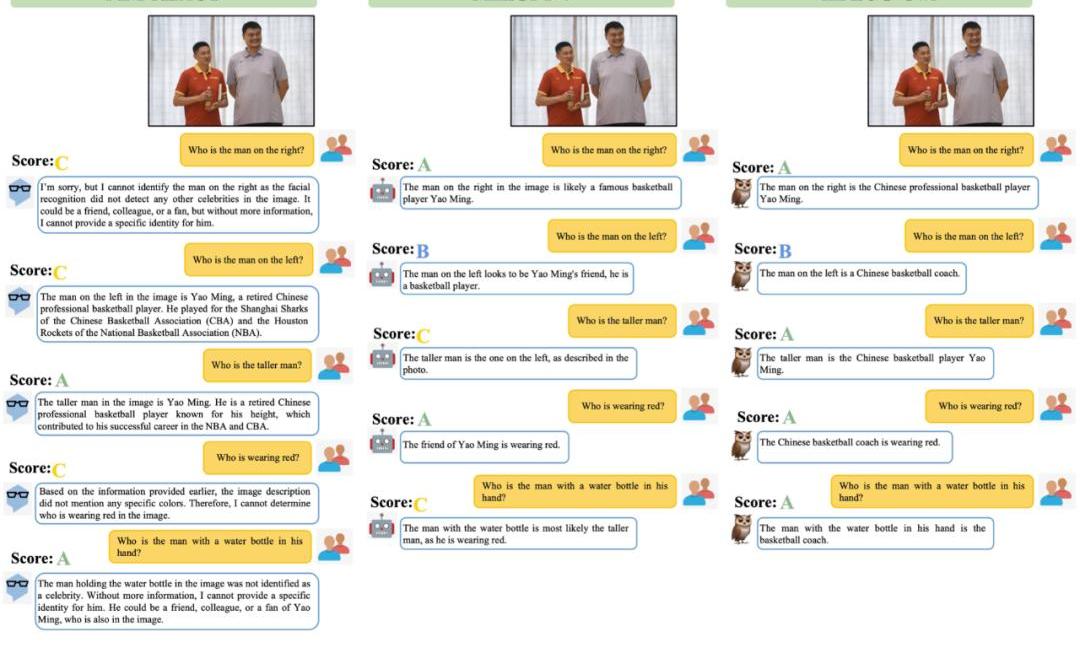

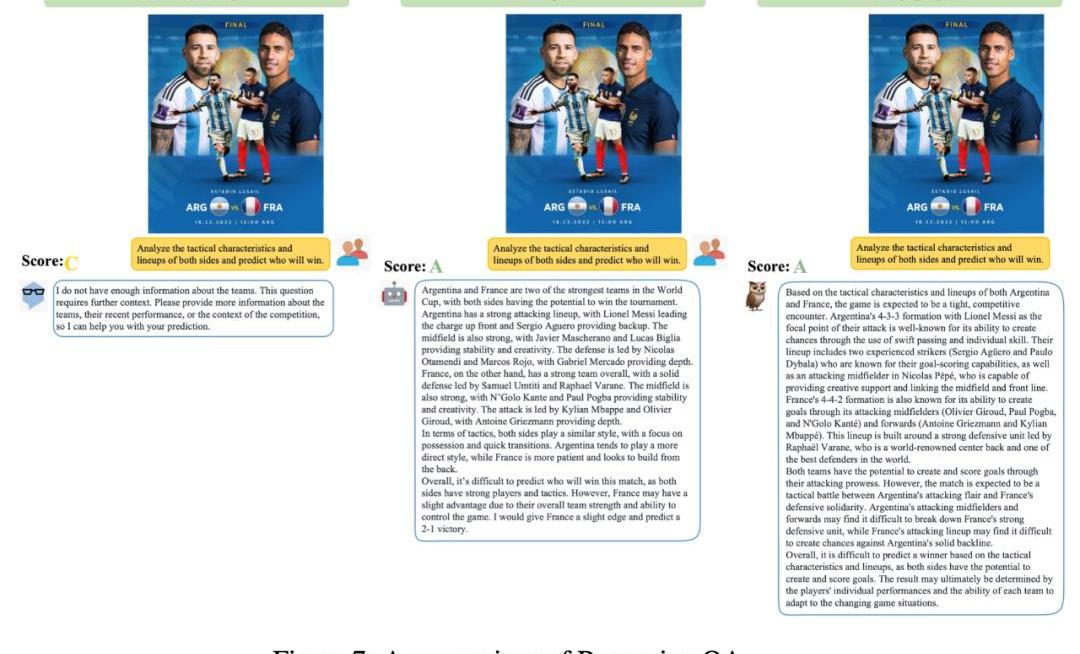

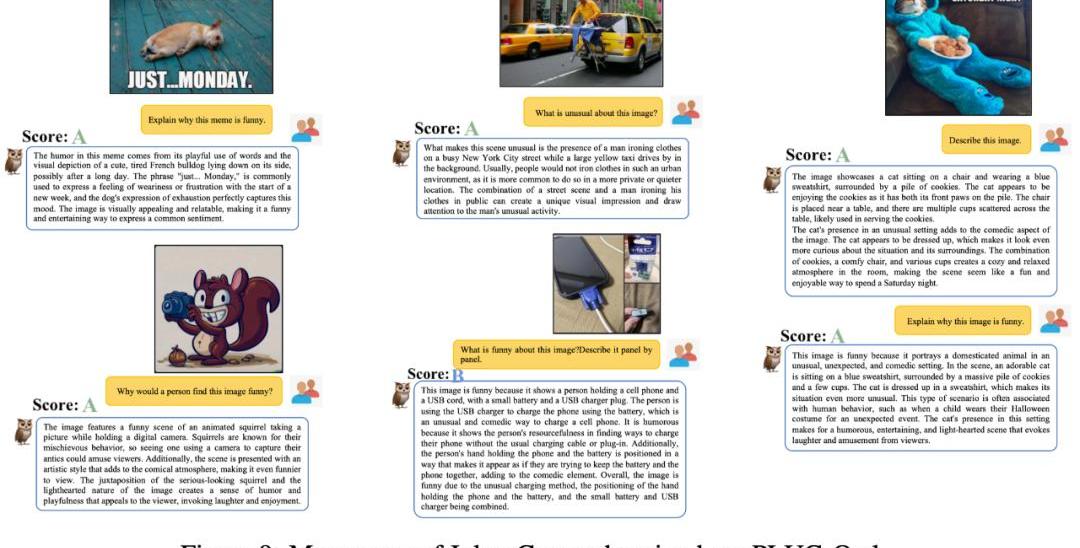

我們把mPLUG-Owl與現有工作進行對比來感受一下mPLUG-Owl的多模態效果,值得一提的是,該工作中評比的測試樣例基本上都來自已有工作,避免了cherrypick問題。

OKX總裁Hong:OKX平臺沉淀資產已超200億美元,是用戶最信任的加密平臺之一:金色財經報道,OKX總裁Hong出席Web3香港嘉年華峰會并公開宣布,目前,OKX全球用戶已經超過5000萬,平臺沉淀資產超200億美元,是用戶最信任的加密平臺之一。

據悉,自去年11月以來,OKX堅持每月公布平臺儲備金證明,據其公布的第五月度儲備金證明(Proof-of-Reserves,簡稱PoR)報告顯示,目前OKX持有的比特幣、以太坊和USDT總價值為89億美元。[2023/4/12 13:58:08]

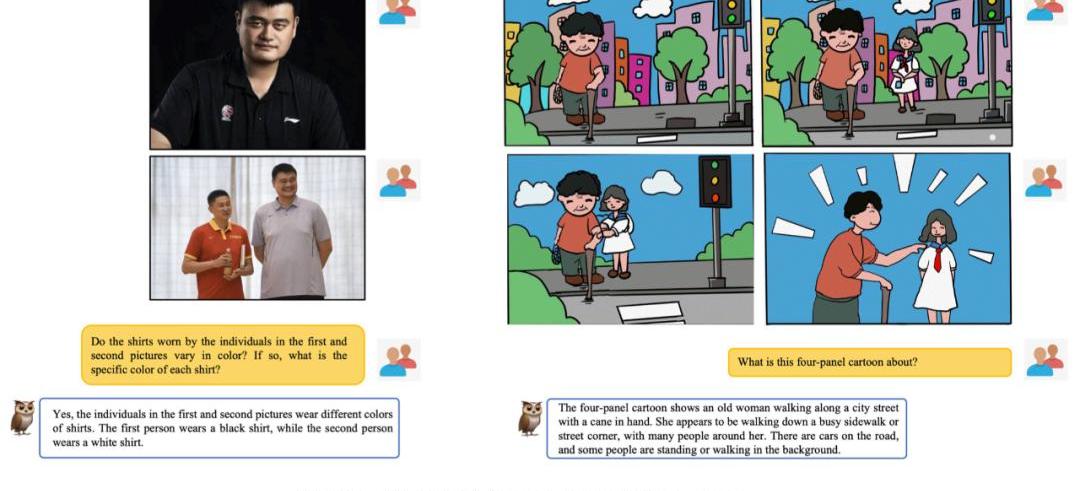

下圖6展示了mPLUG-Owl很強的多輪對話能力。

從圖7中可以發現,?mPLUG-Owl具有很強的推理能力。

WhaleAlert:近一個小時內1000枚BTC和1.5萬枚ETH轉入Crypto.com:金色財經消息,據WhaleAlert數據顯示,近一個小時內1000枚BTC(2150萬美元)和1.5萬枚ETH(約2438萬美元)轉入Crypto.com。。[2022/8/22 12:39:25]

如圖9展示了一些笑話解釋例?。

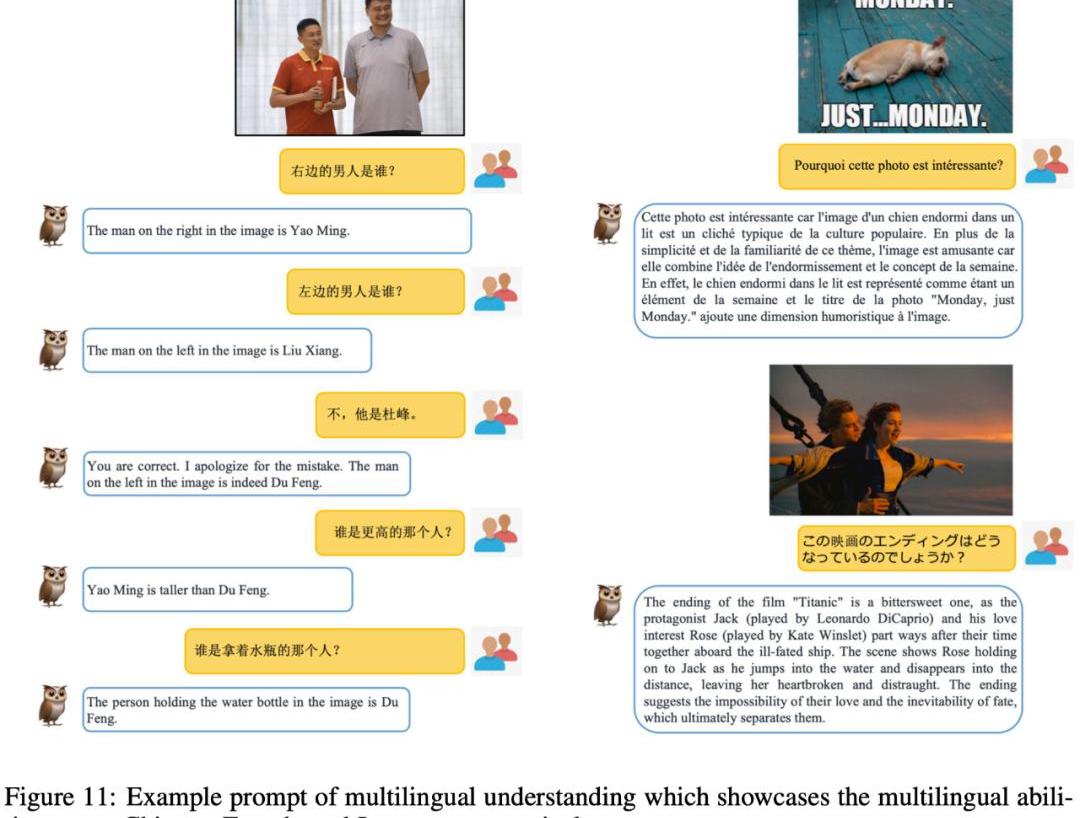

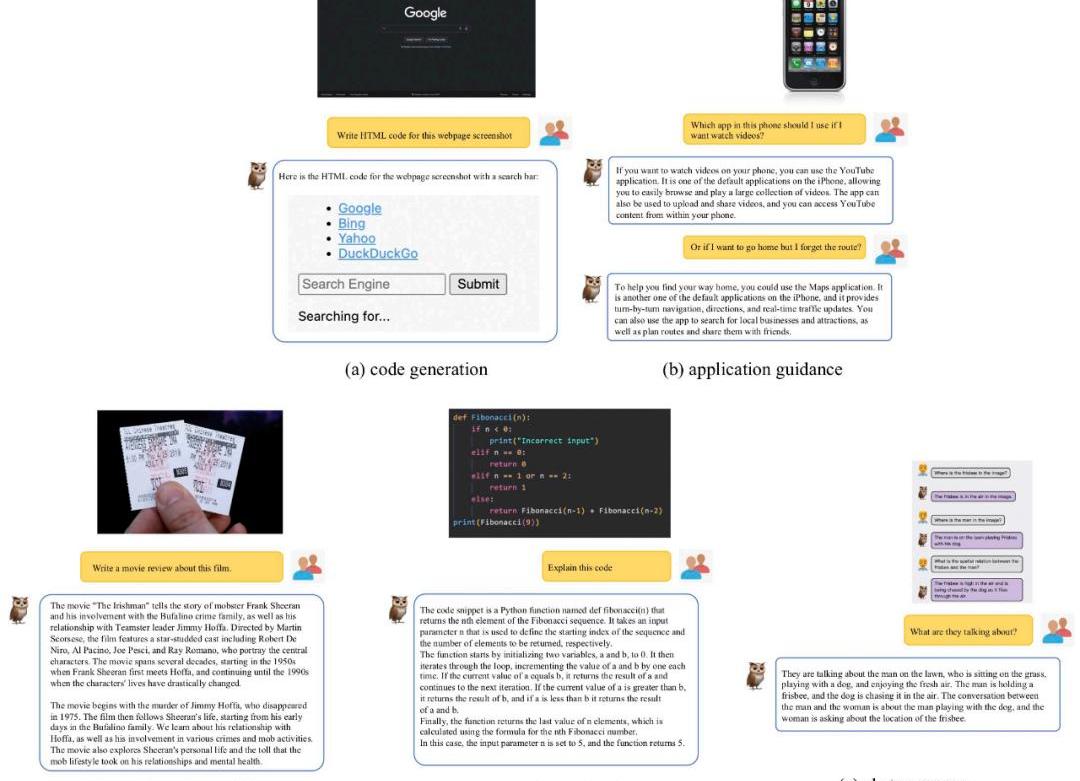

在該工作中,除了評測對比外,該研究團隊還觀察到mPLUG-Owl初顯一些意想不到的能力,比如多圖關聯、多語?、文字識別和文檔理解等能力。

數據:持有至少0.01枚ETH的地址數達近4個月低點:金色財經報道,數據顯示,當前持有至少0.01枚ETH的地址數為22,308,019,達近4個月低點。[2022/8/21 12:37:47]

如圖10所示,雖然在訓練階段并沒有進行多圖關聯數據的訓練,mPLUG-Owl展現出了一定的多圖關聯能力。

如圖11所示,盡管mPLUG-Owl在訓練階段僅使用了英文數據,但其展現出了有趣的多語?能力。這可能是因為mPLUG-Owl中的語?模型使用了LLaMA,從而出現了這一現象。

盡管mPLUG-Owl沒有在帶有標注的文檔數據上進行訓練,但其仍然展現出了一定的文字識別和文檔理解能力,測試結果如圖12所示。

方法介紹

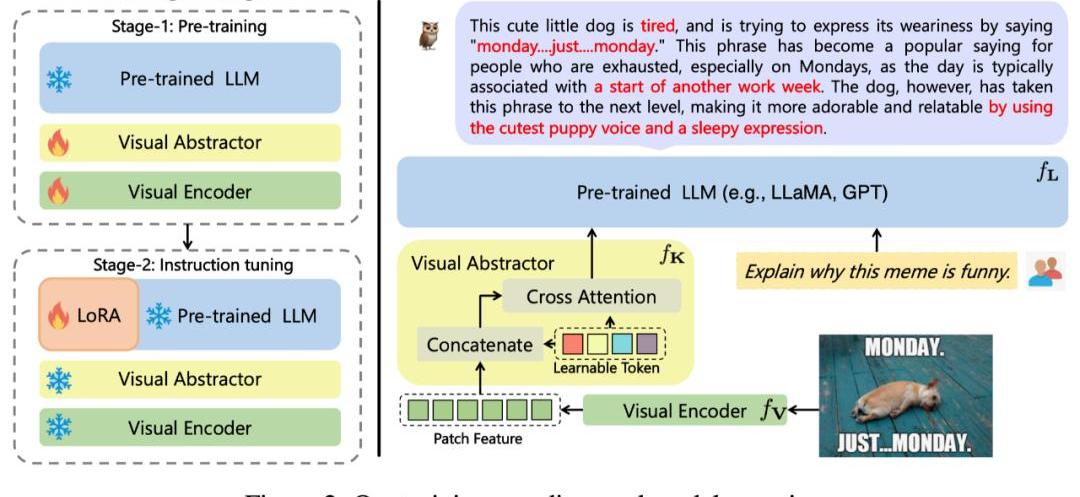

該工作提出的mPLUG-Owl,其整體架構如圖2所示。

模型結構:它由視覺基礎模塊(開源的ViT-L)、視覺抽象模塊以及預訓練語?模型(LLaMA-7B)組成。視覺抽象模塊將較?的、細粒度的圖像特征概括為少量可學習的Token,從而實現對視覺信息的?效建模。?成的視覺Token與文本查詢一起輸?到語?模型中,以?成相應的回復。

模型訓練:采用兩階段的訓練方式

第一階段:主要目的也是先學習視覺和語?模態間的對?。不同于先前的工作,?mPLUG-Owl提出凍住視覺基礎模塊會限制模型關聯視覺知識和文本知識的能力。?因此mPLUG-Owl在第一階段只凍住LLM的參數,采用LAION-400M,?COYO-700M,?CC以及MSCOCO訓練視覺基礎模塊和視覺摘要模塊。

第?階段:延續mPLUG和mPLUG-2中不同模態混合訓練對彼此有收益的發現,Owl在第?階段的指令微調訓練中也同時采用了純文本的指令數據(52kfromAlpaca+90kfromVicuna+50kfromBaize)和多模態的指令數據(150kfromLLaVA)。作者通過詳細的消融實驗驗證了引?純文本指令微調在指令理解等方?帶來的收益。第?階段中視覺基礎模塊、視覺摘要模塊和原始LLM的參數都被凍住,參考LoRA,只在LLM引?少量參數的adapter結構用于指令微調。

實驗結果

SOTA對比

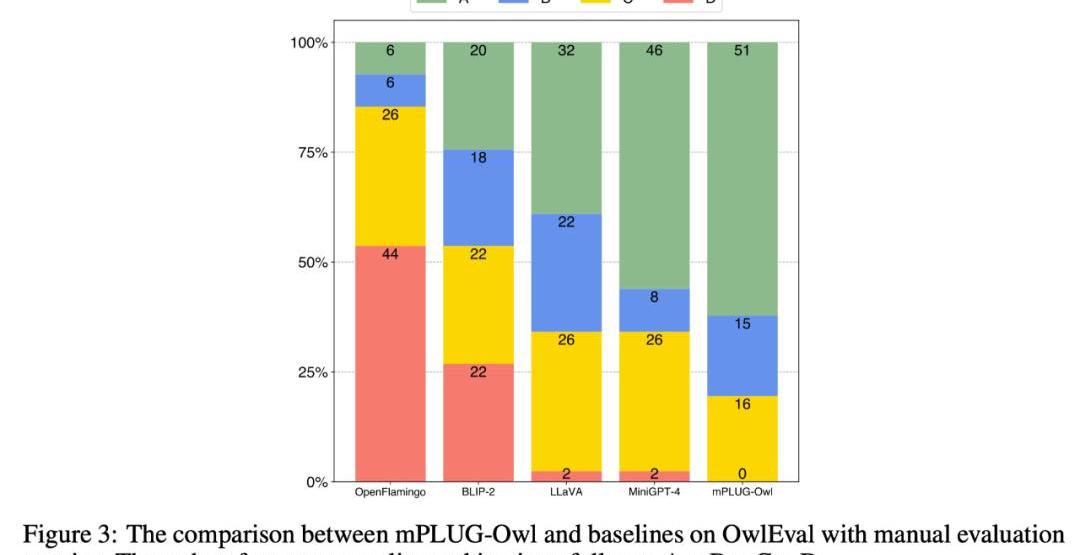

為了比較不同模型的多模態能力,該工作構建一個多模態指令評測集OwlEval。由于?前并沒有合適的自動化指標,參考Self-Intruct對模型的回復進行人工評測,打分規則為:A="正確且令人滿意";B="有一些不完美,但可以接受";C="理解了指令但是回復存在明顯錯誤";D="完全不相關或不正確的回復"。

對比結果如下圖3所示,實驗證明Owl在視覺相關的指令回復任務上優于已有的OpenFlamingo、BLIP-2、LLaVA、MiniGPT-4。

多維度能力對比

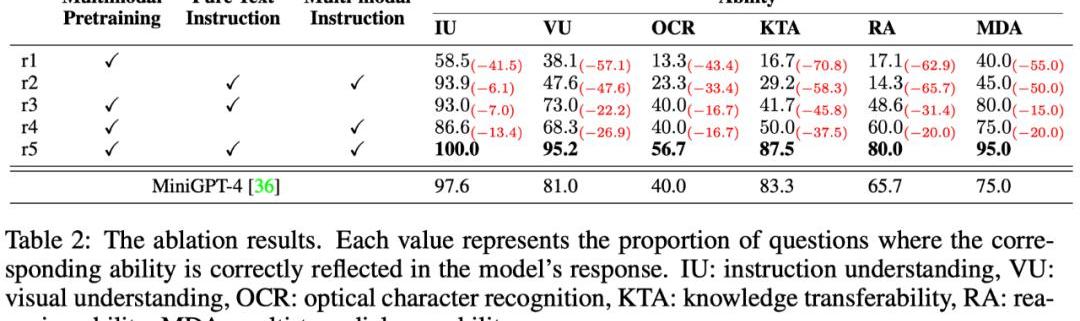

多模態指令回復任務中牽扯到多種能力,例如指令理解、視覺理解、圖?上文字理解以及推理等。為了細粒度地探究模型在不同能力上的?平,本文進一步定義了多模態場景中的6種主要的能力,并對OwlEval每個測試指令人工標注了相關的能力要求以及模型的回復中體現了哪些能力。

結果如下表格6所示,在該部分實驗,作者既進行了Owl的消融實驗,驗證了訓練策略和多模態指令微調數據的有效性,也和上一個實驗中表現最佳的baseline—MiniGPT4進行了對比,結果顯示Owl在各個能力方?都優于MiniGPT4。

Tags:OWLPLUGPLUMPLZero Knowledge Podcastplug幣現價hareplus幣野兔最新消息MPLAY

博鏈財經BroadChain獲悉,4月30日,據BeInCrypto,根據21SharesResearch編制的數據,信標鏈上大約90%的質押以太坊完全提款發生在中心化交易所.

1900/1/1 0:00:00來源:《科創板日報》 編輯鄭遠方 圖片來源:由無界AI工具生成“三項能力超過ChatGPT”、“10月24日將整體超過GPT水平”,5月6日,科大訊飛星火認知大模型發布會現場.

1900/1/1 0:00:00頭條 ▌Block已經完成其新的比特幣挖礦芯片的設計金色財經報道,Twitter前首席執行官JackDorsey擁有的金融服務和技術公司Block宣布已完成其5nm比特幣挖礦芯片原型設計.

1900/1/1 0:00:00來源:量子位 從Meta的LLaMA發展出的羊駝家族一系列大模型,已成為開源AI重要力量。但LLamA開源了又沒全開,只能用于研究用途,還得填申請表格等,也一直被業界詬病.

1900/1/1 0:00:00來源:AI商業研究所 導讀: GeoffreyHinton被稱為“人工智能教父”,從上世紀80年代開始研究神經網絡,是這個領域從業時間最長的人.

1900/1/1 0:00:00來源:量子位 作者:蕭簫 大模型們胡說八道太嚴重,英偉達看不下去了。他們正式推出了一個新工具,幫助大模型說該說的話,并回避不應該觸碰的話題.

1900/1/1 0:00:00