BTC/HKD-0.91%

BTC/HKD-0.91% ETH/HKD-2.89%

ETH/HKD-2.89% LTC/HKD-2.51%

LTC/HKD-2.51% ADA/HKD-1.98%

ADA/HKD-1.98% SOL/HKD-3.04%

SOL/HKD-3.04% XRP/HKD-3.77%

XRP/HKD-3.77%來源:新智元

開源先鋒StabilityAI一天扔了兩枚重磅炸彈:發布史上首個開源RLHF大語言模型,以及像素級圖像模型DeepFloydIF。開源社區狂喜!

最近,大名鼎鼎的StableDiffusion背后的公司,一連整了兩個大活。

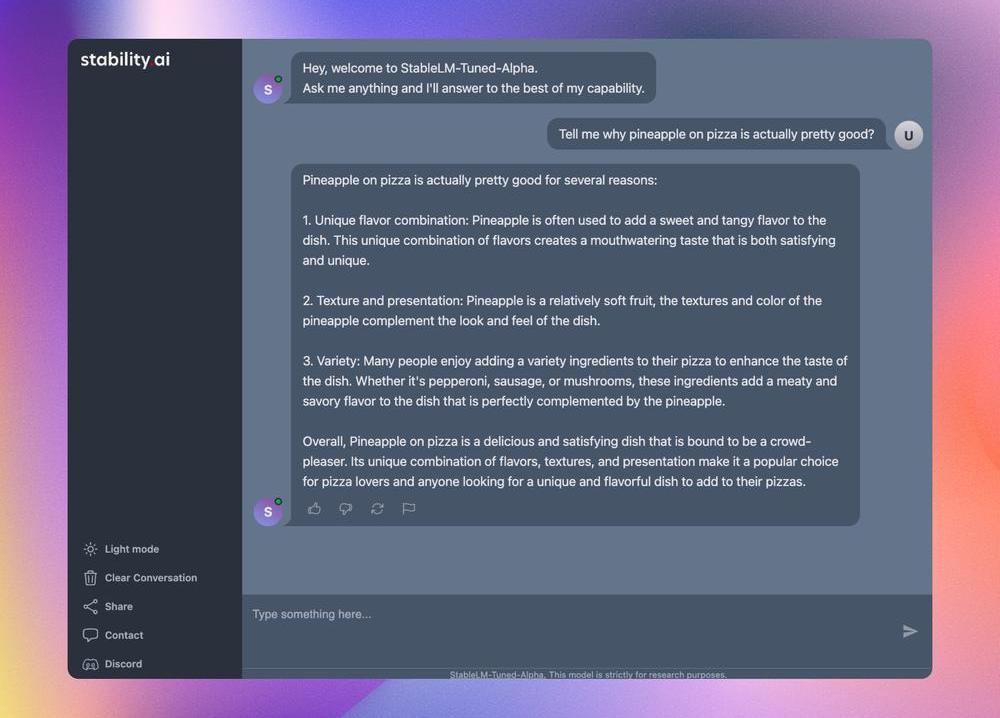

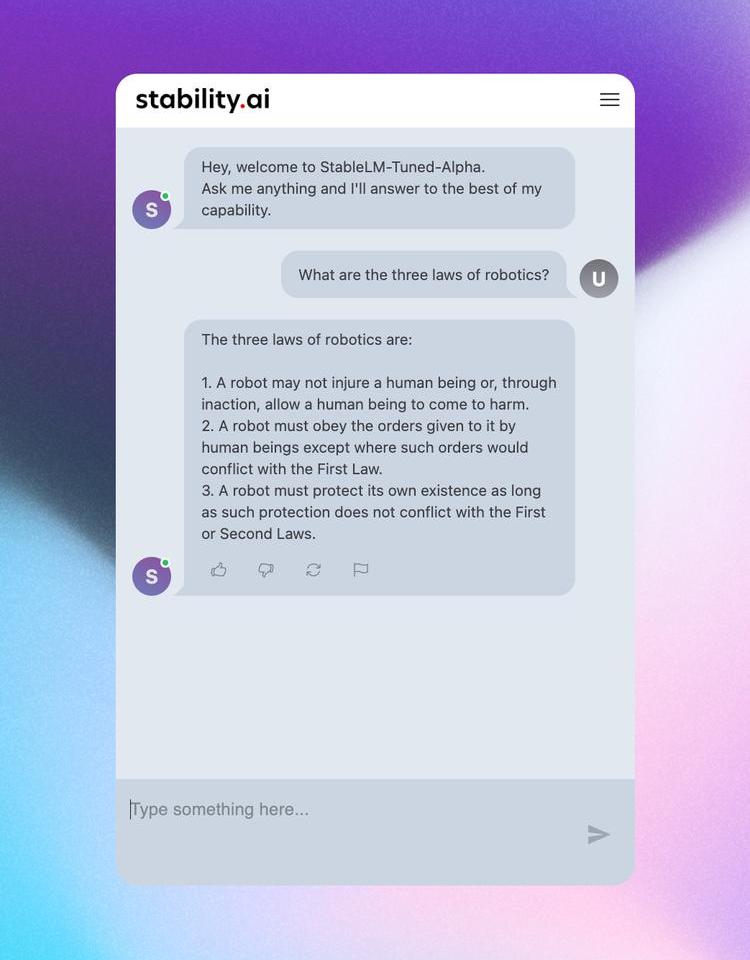

首先,StabilityAI重磅發布了世上首個基于RLHF的開源LLM聊天機器人——StableVicuna。

StableVicuna基于Vicuna-13B模型實現,是第一個使用人類反饋訓練的大規模開源聊天機器人。

有網友經過實測后表示,StableVicuna就是目前當之無愧的13BLLM之王!

對此,1xexited創始人表示,這可以看作是自ChatGPT推出以來的第二個里程碑。

另外,StabilityAI發布了開源模型DeepFloydIF,這個文本到圖像的級聯像素擴散模型功能超強,可以巧妙地把文本集成到圖像中。

這個模型的革命性意義在于,它一連解決了文生圖領域的兩大難題:正確生成文字,正確理解空間關系!

秉持著開源的一貫傳統,DeepFloydIF在以后會完全開源。

StailibityAI,果然是開源界當之無愧的扛把子。

StableVicuna

世上首個開源RLHFLLM聊天機器人StableVicuna,由StabilityAI震撼發布!

數據:StarkNet橋接用戶量突破30萬,逼近Optimism:金色財經報道,據Dune Analytics最新數據顯示,以太坊Layer 2網絡StarkNet橋接用戶量已突破30萬,本文撰寫時達到305,628個,橋接存儲總價值為37,805 ETH,按照當前價格計算約合7000萬美元。此外,StarkNet橋接用戶量正逼近Optimism,后者該指標的當前值為317,374個。[2023/4/9 13:53:37]

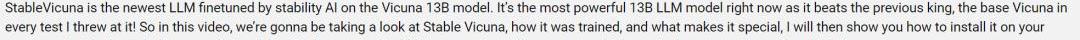

一位Youtube主播對StableVicuna進行了實測,StableVicuna在每一次測試中,都擊敗了前任王者Vicuna。

所以這位Youtuber激動地喊出:StableVicuna就是目前最強大的13BLLM模型,是當之無愧的LLM模型之王!

StableVicuna基于小羊駝Vicuna-13B模型實現,是Vicuna-13B的進一步指令微調和RLHF訓練的版本。

而Vicuna-13B是LLaMA-13B的一個指令微調模型。

從以下基準測試可以看出,StableVicuna與類似規模的開源聊天機器人在整體性能上的比較。

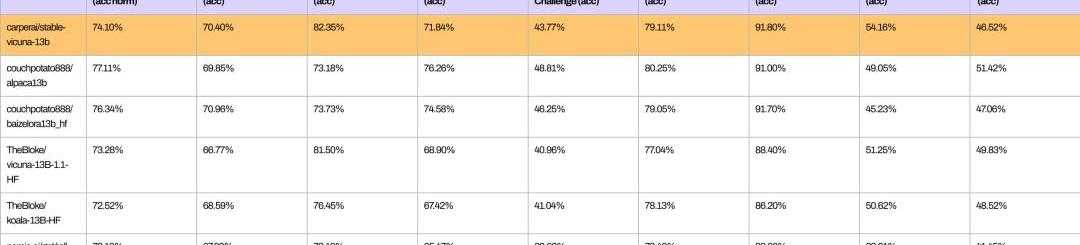

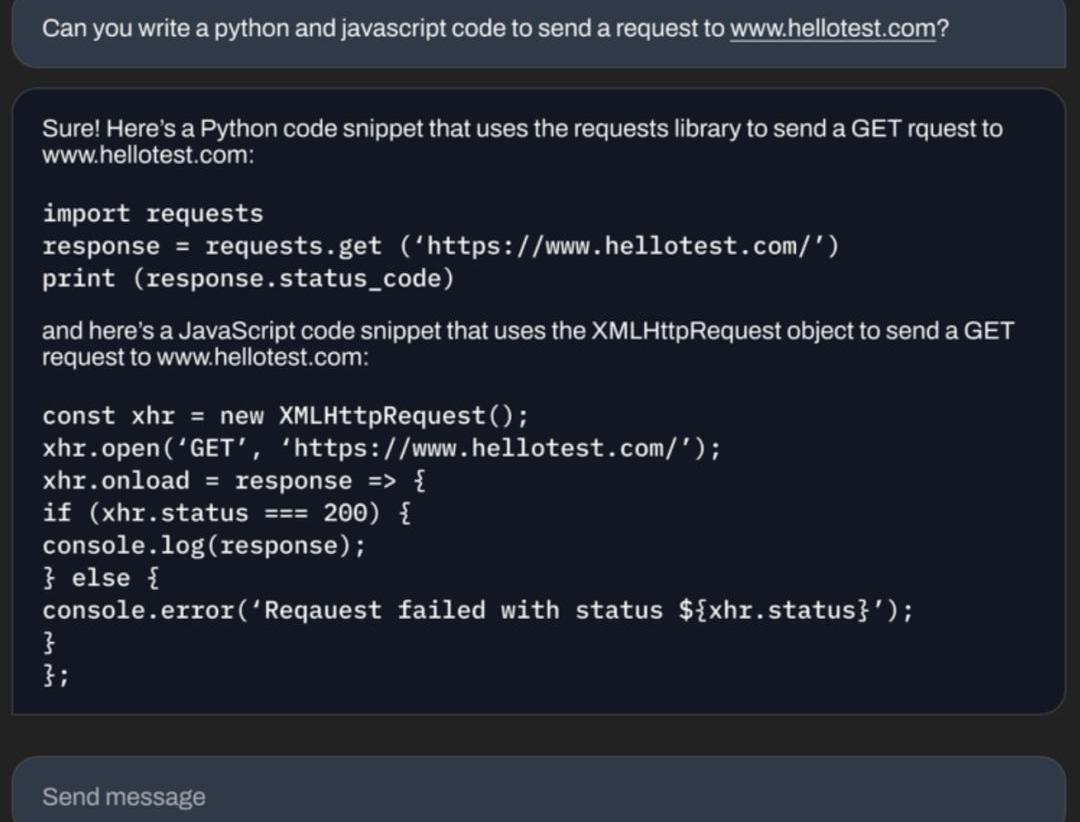

StableVicuna可以做基礎數學題。

State Street宣布增持Silvergate股份至9.3%:金色財經報道,根據周四向美國證券交易委員會 (SEC)提交的一份文件,截至 12 月 31 日,State Street 披露了其持有加密貨幣貸款機構 Silvergate Capital (SI) 9.3% 的股份。本月早些時候有報道稱,該資產管理公司曾持有 Silvergate 5.3% 的股份。本周早些時候,另一家基金管理巨頭BlackRock披露,截至年底持有 Silvergate股份的比例從之前的 6.3% 增至 7.2%。

根據 2022 年 2 月提交的一份文件,基金經理 Vanguard 也是 Silvergate 的大股東,截至 2021 年 12 月 31 日持有該公司 8.59% 的股份。除了周四加密貨幣相關股票的大幅上漲外,Silvergate 的股價飆升了 38%,今年迄今已上漲 30% 。[2023/2/3 11:44:26]

可以寫代碼。

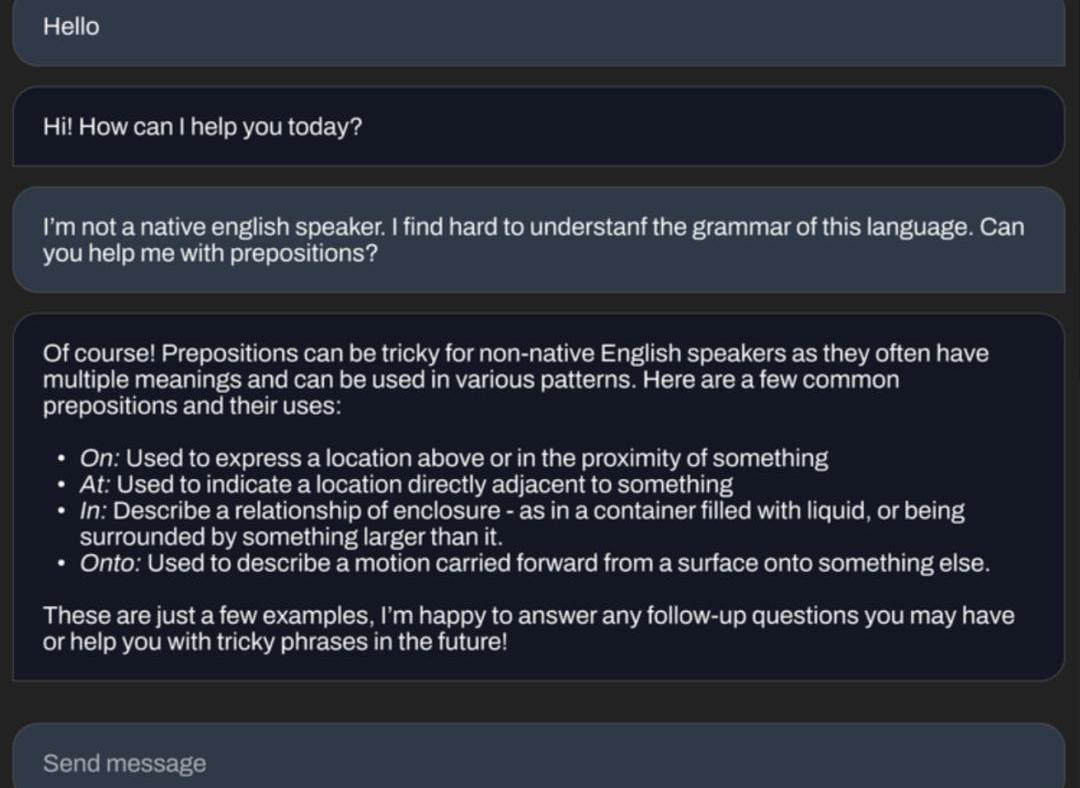

還能為你講解語法知識。

開源聊天機器人平替狂潮

StabilityAI想做這樣一個開源的聊天機器人,當然也是受了此前LLaMa權重泄露引爆的ChatGPT平替狂潮的影響。

從去年春天Character.ai的聊天機器人,到后來的ChatGPT和Bard,都引發了大家對開源平替的強烈興趣。

這些聊天模型的成功,基本都歸功于這兩種訓練范式:指令微調和人類反饋強化學習(RLHF)。

這期間,開發者一直在努力構建開源框架幫助訓練這些模型,比如trlX、trl、DeepSpeedChat和ColossalAI等,然而,卻并沒有一個開源模型,能夠同時應用指令微調和RLHF。

V神:新書《Proof of Stake》即將出版,讀者可在Gitcoin上捐贈并獲取紀念NFT:8月31日消息,V神在其社交平臺表示,其近十年文集《Proof of Stake》數字版和實物版將出版。讀者現可在Gitcoin為其捐贈并獲得數字副本和紀念NFT,全部收益將用于公益事業。[2022/8/31 12:59:45]

大多數模型都是在沒有RLHF的情況下進行指令微調的,因為這個過程十分復雜。

最近,OpenAssistant、Anthropic和Stanford都開始向公眾提供RLHF數據集。

StabilityAI把這些數據集與trlX提供的RLHF相結合,就得到了史上第一個大規模指令微調和RLHF模型——StableVicuna。

訓練過程

為了實現StableVicuna的強大性能,研究者利用Vicuna作為基礎模型,并遵循了一種典型的三級RLHF管線。

Vicuna在130億參數LLaMA模型的基礎上,使用Alpaca進行調整后得到的。

他們混合了三個數據集,訓練出具有監督微調(SFT)的Vicuna基礎模型:

OpenAssistantConversationsDataset(OASST1),一個人工生成的、人工注釋的助理式對話語料庫,包含161,443條消息,分布在66,497個對話樹中,使用35種不同的語言;

GPT4AllPromptGenerations,由GPT-3.5Turbo生成的437,605個提示和響應的數據集;

Alpaca,這是由OpenAI的text-davinci-003引擎生成,包含52,000條指令和演示的數據集。

研究者使用trlx,訓練了一個獎勵模型。在以下這些RLHF偏好數據集上,研究者得到了SFT模型,這是獎勵模型的基礎。

OpenAssistantConversationsDataset(OASST1),包含7213個偏好樣本;

WhaleStats:市場崩盤后,加密巨鯨入購1710億枚SHIB:11月17日消息,據WhaleStats數據顯示,在全球加密貨幣市場崩盤之后,有巨鯨購買共計1710億枚SHIB。

據悉,隨著市場對巨鯨的控制越來越多,市場參與者預計趨勢會逆轉。在SHIB達到之前的ATH后,巨鯨的網絡份額略有下降,導致在不到一周的時間內大幅調整了45%。[2021/11/17 21:58:38]

AnthropicHH-RLHF,一個關于AI助手有用性和無害性的偏好數據集,包含160,800個人類標簽;

斯坦福人類偏好(SHP),這是一個數據集,包含348,718個人類對各種不同回答的集體偏好,包括18個從烹飪到哲學的不同學科領域。

最后,研究者使用了trlX,進行近端策略優化(ProximalPolicyOptimization,PPO)強化學習,對SFT模型進行了RLHF訓練,然后,StableVicuna就誕生了!

據StabilityAI稱,會進一步開發StableVicuna,并且會很快在Discord上推出。

另外,StabilityAI還計劃給StableVicuna一個聊天界面,目前正在開發中。

相關演示已經可以在HuggingFace上查看了,開發者也可以在HuggingFace上下載模型的權重,作為原始LLaMA模型的增量。

但如果想使用StableVicuna,還需要獲得原始LLaMA模型的訪問權限。

獲得權重增量和LLaMA權重后,使用GitHub存儲庫中提供的腳本將它們組合起來,就能得到StableVicuna-13B了。不過,也是不允許商用的。

JustStable目前USDJ供應量已達到2.86億美金,TRX質押量已達到151億個:據 just.tronscan.org瀏覽器數據顯示,JustStable目前USDJ供應量已達到2.86億美金,TRX質押量已達到151億個。據悉,JUST是在波場TRON上運行的第一個DeFi項目,旨在打造基于波場TRON的穩定幣借貸平臺,同時也是數字交易平臺、交易量曾登頂全球Top3的Poloniex LaunchBase首期上線項目。

JUST是一個雙代幣系統。第一個代幣 USDJ 是按 1:1 的匯率與美元掛鉤的穩定幣,是通過 JUST 的 CDP 門戶抵押 TRX 產生的。第二個代幣 JST可用于支付利息,平臺維護,通過投票參與治理以及 JUST 平臺上的其他活動。[2021/4/20 20:40:22]

DeepFloydIF

在同一時間,StabilityAI還放出了一個大動作。

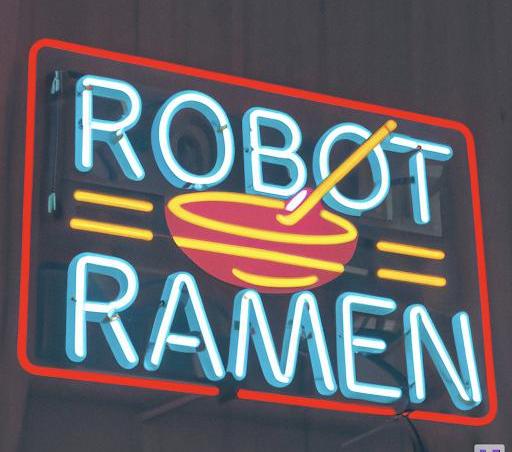

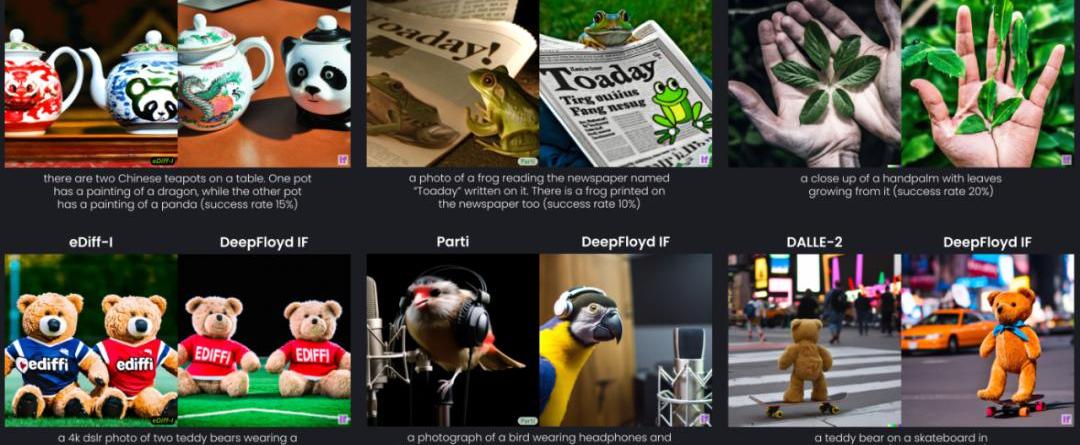

你敢信,AI一直無法正確生成文字這個老大難問題,竟然被解決了?

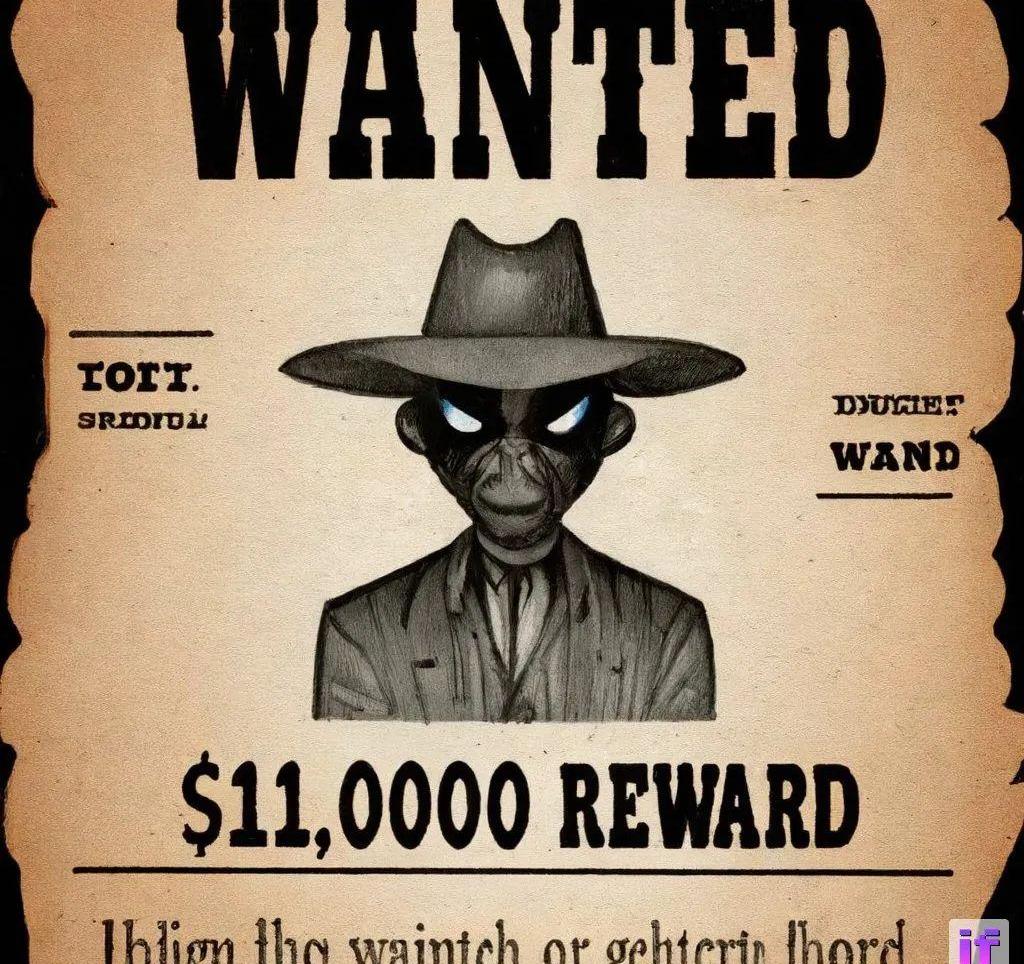

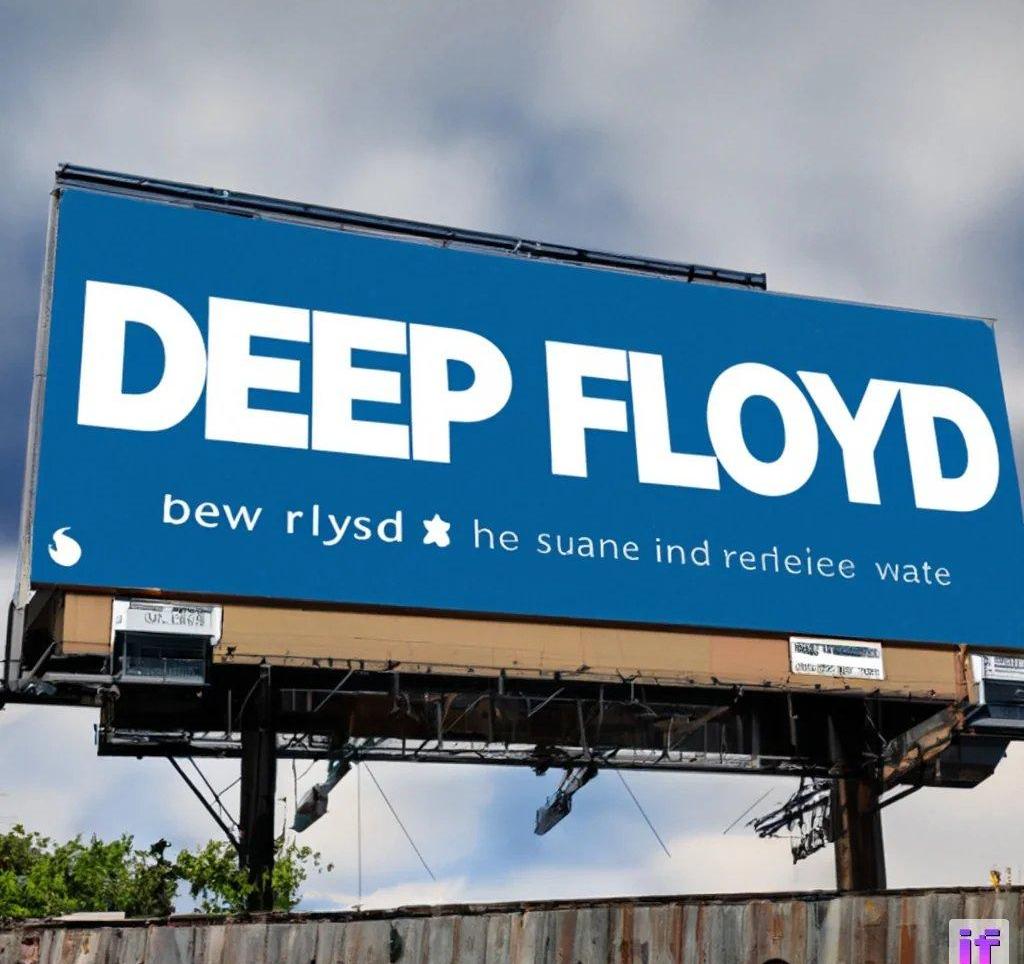

沒錯,下面這張「完美」的招牌,就是由StabilityAI全新推出的開源圖像生成模型——DeepFloydIF制作的。

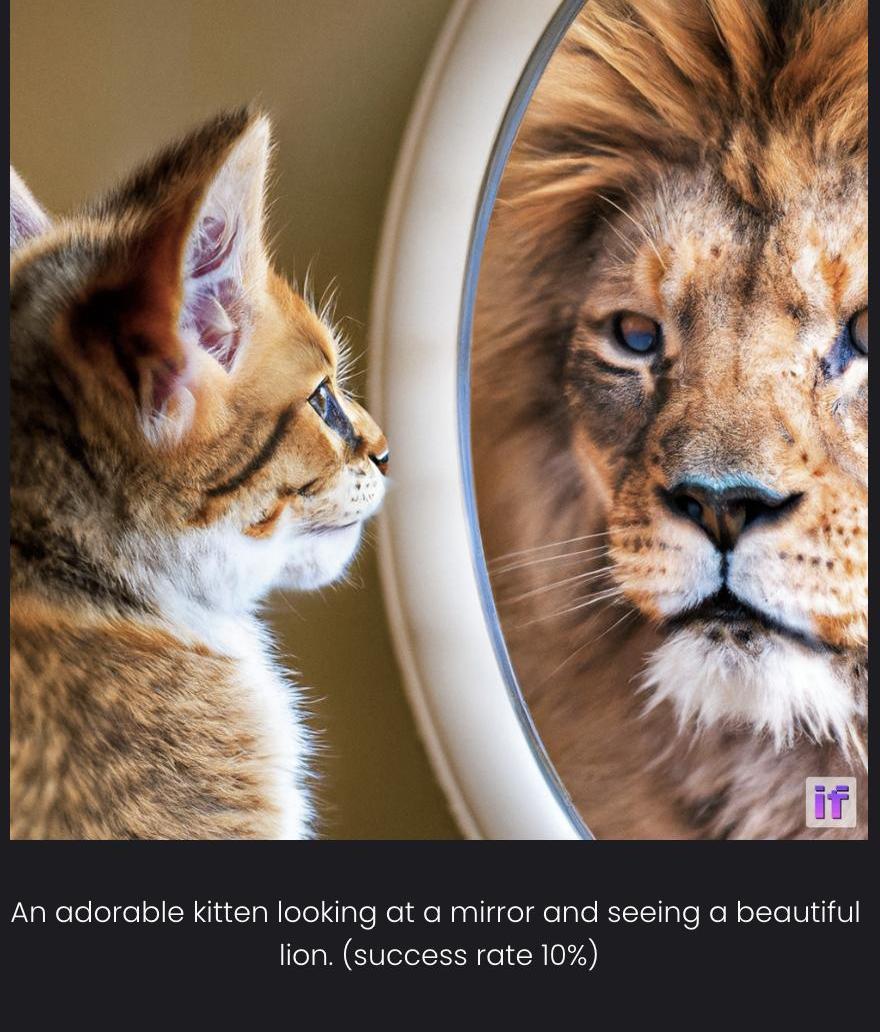

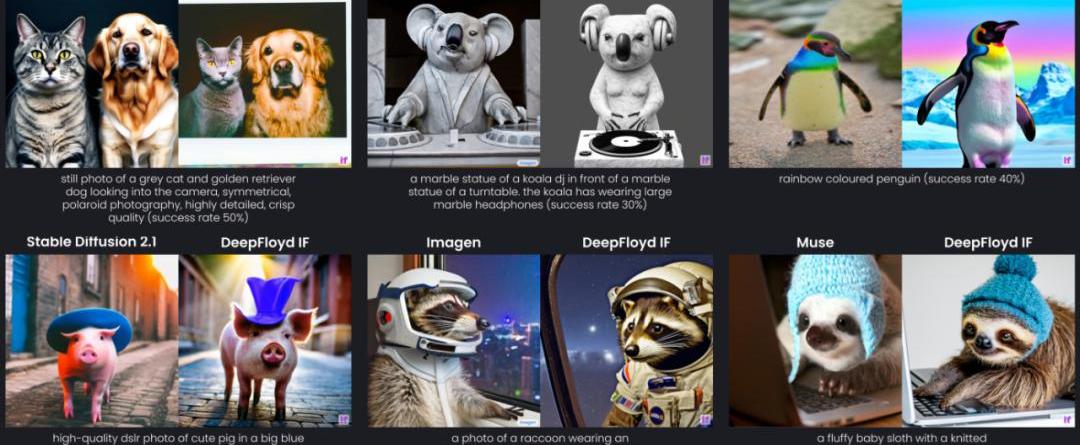

除此之外,DeepFloydIF還能夠生成正確的空間關系。

模型剛一發布,網友們已經玩瘋了:

prompt:Robotholdinganeonsignthatsays"Icanspell".

不過,對于prompt中沒有明確說明的文字,DeepFloydIF大概率還是會出錯。

prompt:AneonsignofanAmericanmotelatnightwiththesignjavilop

官方演示

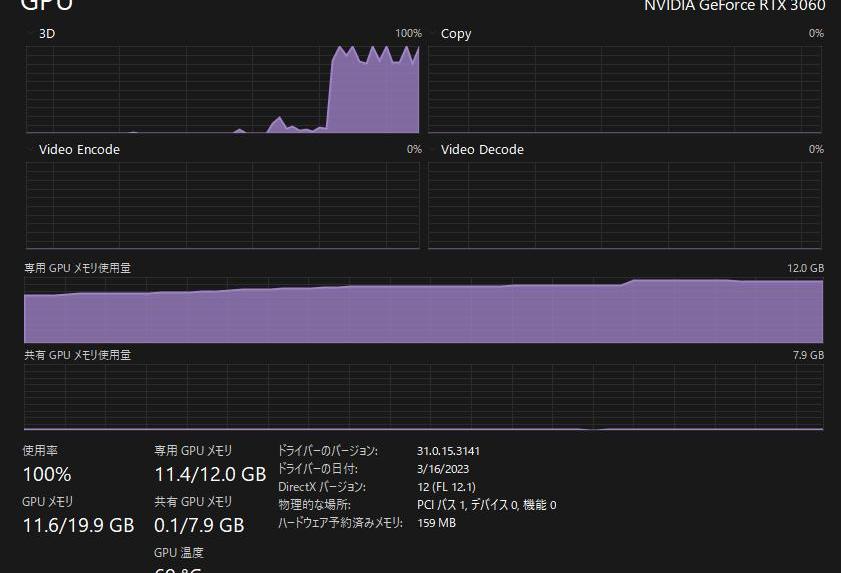

順便一提,在硬件的需求上,如果想要實現模型所能支持的最大1,024x1,024像素輸出,建議使用24GB的顯存;如果只要256x256像素,16GB的顯存即可。

是的,RTX306016G就能跑。

代碼實現:https://gist.github.com/Stella2211/ab17625d63aa03e38d82ddc8c1aae151

開源版谷歌Imagen

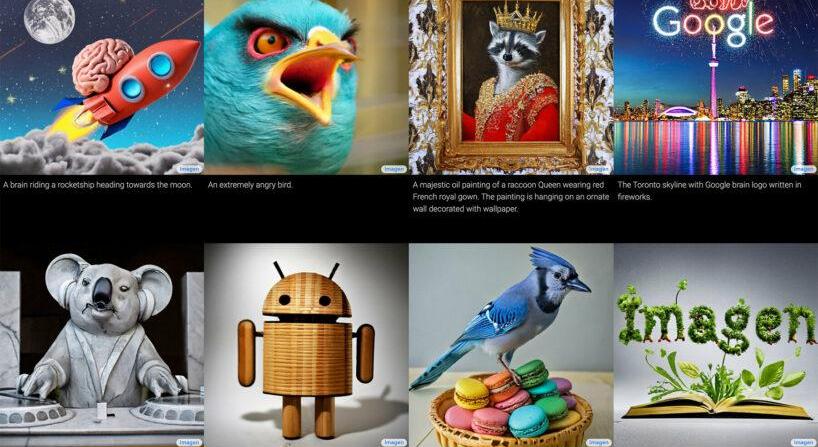

2022年5月,谷歌高調發布了自家的圖像生成模型Imagen。

根據官方演示的效果,Imagen不僅在質量上完勝OpenAI最強的DALL-E2,更重要的是——它能夠正確地生成文本。

迄今為止,沒有任何一個開源模型能夠穩定地實現這一功能。

與其他生成式AI模型一樣,Imagen也依賴于一個凍結的文本編碼器:先將文本提示轉換為嵌入,然后由擴散模型解碼成圖像。但不同的是,Imagen并沒有使用多模態訓練的CLIP,而是使用了大型T5-XXL語言模型。

這次,StabilityAI推出的DeepFloydIF復刻的正是這一架構。

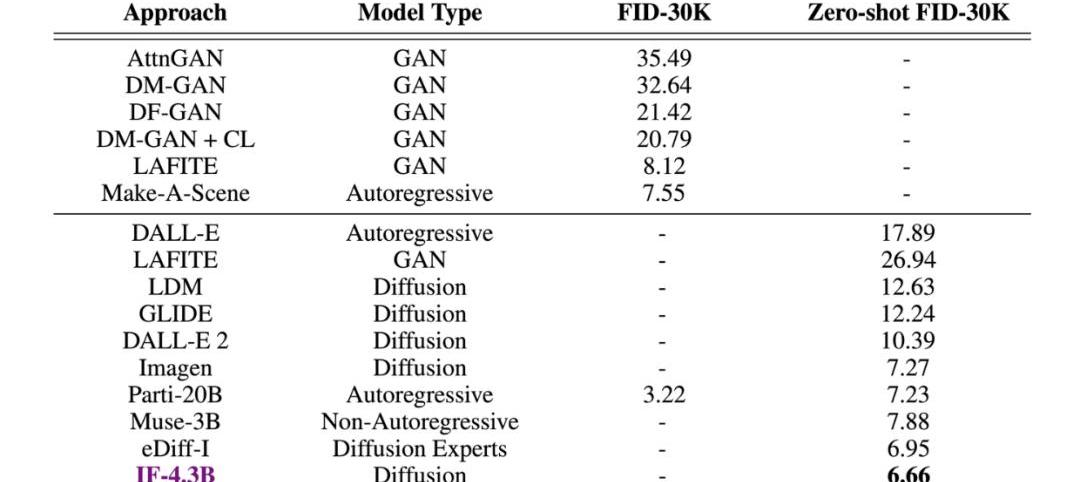

甚至在測試中,DeepFloydIF憑借著COCO數據集上6.66的zero-shotFID分數,直接超越了谷歌的Imagen,以及一眾競品。

下一代圖像生成AI模型

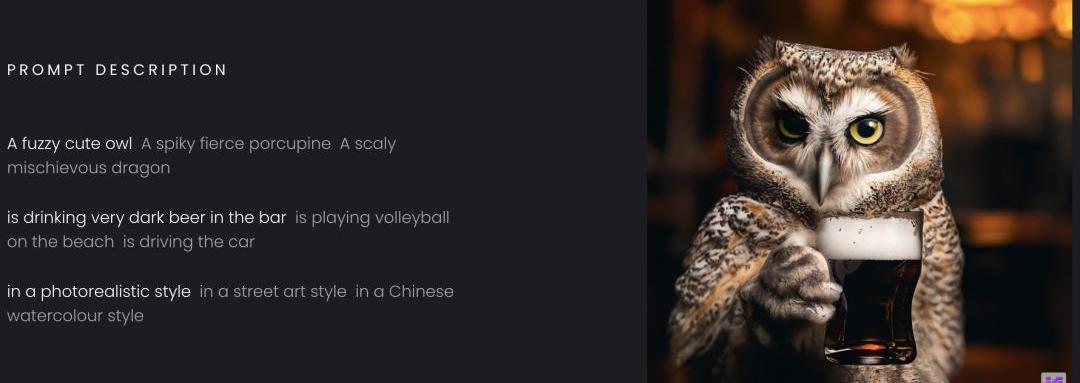

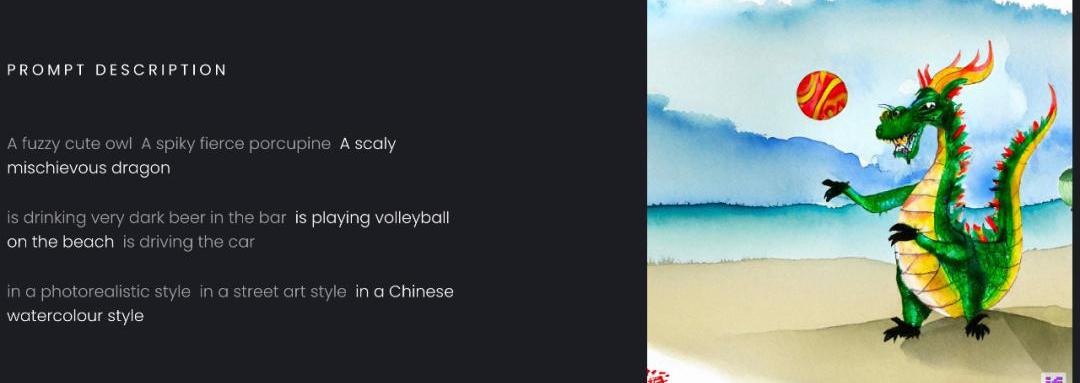

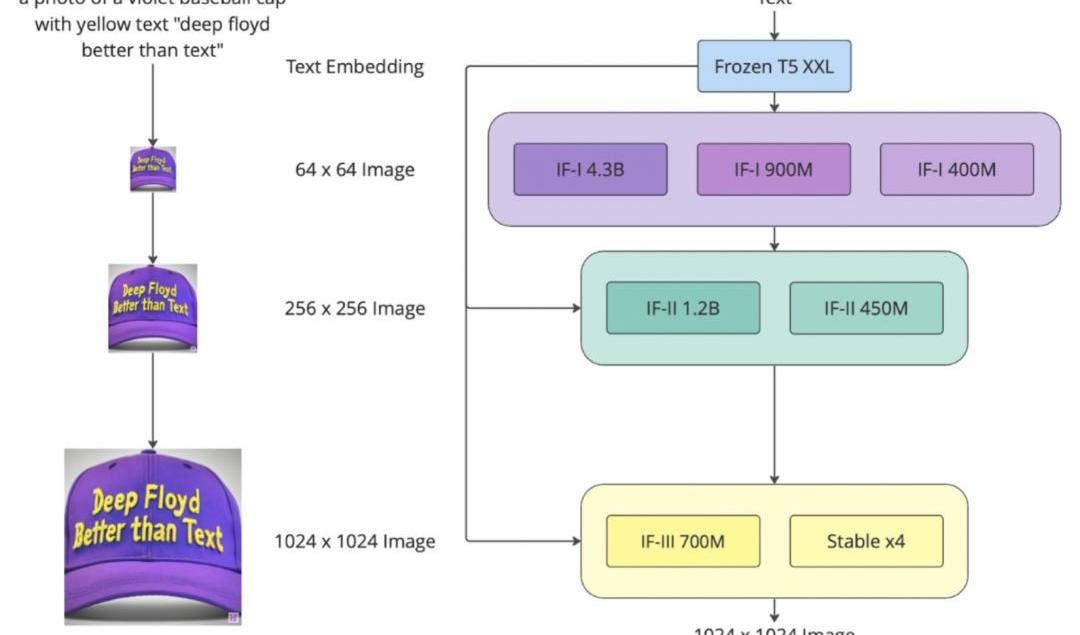

具體來說,DeepFloydIF是一個模塊化、級聯的像素擴散模型。

模塊化:

DeepFloydIF由幾個神經模塊組成,它們在一個架構中相互協同工作。

級聯:

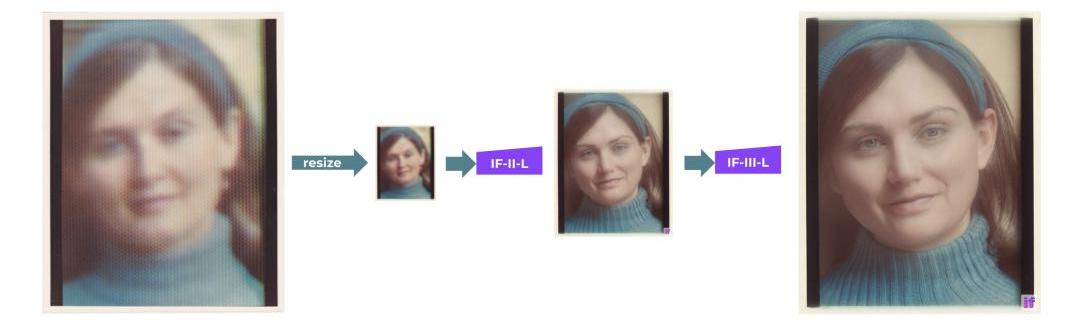

DeepFloydIF以多個模型級聯的方式實現高分辨率輸出:首先生成一個低分辨率的樣本,然后通過連續的超分辨率模型進行上采樣,最終得到高分辨率圖像。

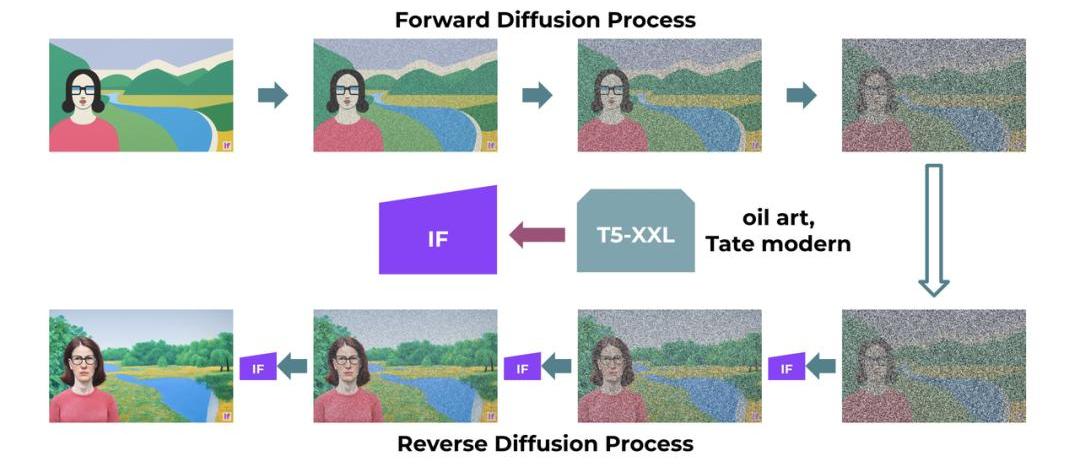

擴散:

DeepFloydIF的基本模型和超分辨率模型都是擴散模型,其中使用馬爾可夫鏈的步驟將隨機噪聲注入到數據中,然后反轉該過程從噪聲中生成新的數據樣本。

像素:

DeepFloydIF在像素空間工作。與潛在擴散模型不同,擴散是在像素級別實現的,其中使用潛在表征。

上面這個流程圖展示的就是,DeepFloydIF三個階段的性能:

階段1:

基本擴散模型將定性文本轉換為64x64圖像。DeepFloyd團隊已經訓練了三個版本的基本模型,每個版本都有不同的參數:IF-I400M、IF-I900M和IF-I4.3B。

階段2:

為了「放大」圖像,團隊將兩個文本條件超分辨率模型應用于基本模型的輸出。其中之一將64x64圖像放大到256x256圖像。同樣,這個模型也有幾個版本:IF-II400M和IF-II1.2B。

階段3:

應用第二個超分辨率擴散模型,生成生動的1024x1024圖像。最后的第三階段模型IF-III擁有700M參數。

值得注意的是,團隊還沒有正式發布第三階段的模型,但DeepFloydIF的模塊化特性讓我們可以使用其他上采樣模型——如StableDiffusionx4Upscaler。

團隊表示,這項工作展示了更大的UNet架構在級聯擴散模型的第一階段的潛力,從而為文本到圖像合成展示了充滿希望的未來。

數據集訓練

DeepFloydIF是在一個定制的高質量LAION-A數據集上進行訓練的,該數據集包含10億對。

LAION-A是LAION-5B數據集英文部分的一個子集,基于相似度哈希去重后獲得,對原始數據集進行了額外的清理和修改。DeepFloyd的定制過濾器用于刪除水印、NSFW和其他不適當的內容。

目前,DeepFloydIF模型的許可僅限于非商業目的的研究,在完成反饋的收集之后,DeepFloyd和StabilityAI團隊將發布一個完全免費的商業版本。

參考資料:

https://stability.ai/blog/stablevicuna-open-source-rlhf-chatbot

https://stability.ai/blog/deepfloyd-if-text-to-image-model

Nayms是一家保險科技公司,傳統保險業不透明、緩慢且效率低的下,新項目?Nayms?通過引入區塊鏈技術,讓保險行業變得透明和高效,同時將風險定價和保險業務管理提升到了一個新的水平.

1900/1/1 0:00:00區塊鏈通過數十個為全球數百萬用戶提供服務的開放和無需許可的網絡,為互聯網提供了一種完全透明的方法.

1900/1/1 0:00:00王融?騰訊研究院首席數據法律專家 本期觀點摘要: 1.ChatGPT等AI應用服務商直接面向個人提供服務,收集并處理個人信息,可被視為個人信息保護合規主體——數據控制者.

1900/1/1 0:00:00概述 在上一篇文章中,我們提出了一個構建鏈上游戲的框架——ActionRegistryCore。在深入探討ARC的復雜性之前,我們有必要先退一步,探討一下構建鏈上游戲的初衷.

1900/1/1 0:00:00作者:中國銀行軟件中心?鄧偉財隨著科技發展的突飛猛進,尤其是金融科技發展水平的不斷提升,金融科技的綜合應用程度成為衡量商業銀行競爭力和軟實力的重要組成部分.

1900/1/1 0:00:00來源丨元宇宙簡史 編寫丨元宇宙簡史主理人Fun5月9日,抖音發布了關于人工智能生成內容的平臺規范暨行業倡議,以及《抖音關于人工智能生成內容標識的水印與元數據規范》.

1900/1/1 0:00:00