BTC/HKD+0.99%

BTC/HKD+0.99% ETH/HKD+3.35%

ETH/HKD+3.35% LTC/HKD+1.15%

LTC/HKD+1.15% ADA/HKD+2.8%

ADA/HKD+2.8% SOL/HKD+1.1%

SOL/HKD+1.1% XRP/HKD-0.03%

XRP/HKD-0.03%作者:@於方仁 @Caroline Sun

編排:@黑羽小斗

LLM

大型語言模型(LLM, Large Language Model)是利用海量的文本數據進行訓練海量的模型參數。大語言模型的使用,大體可以分為兩個方向:

A. 僅使用

B. 微調后使用

僅使用又稱 Zero-shot,因為大語言模型具備大量通用的語料信息,量變可以產生質變。即使 Zero-shot 也許沒得到用戶想要的結果,但加上合適的 prompt 則可以進一步獲取想要的知識。該基礎目前被總結為 prompt learning。

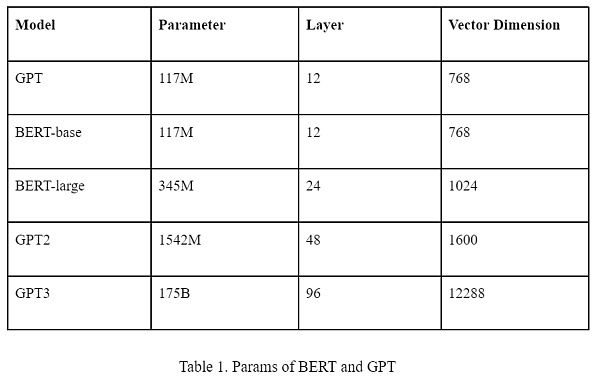

大語言模型,比較流行的就是 BERT 和 GPT。從生態上講 BERT 與 GPT 最大的區別就是前者模型開源,后者只開源了調用 API ,也就是目前的 ChatGPT。

兩個模型均是由若干層的 Transformer 組成,參數數量等信息如下表所示。

目前生態上講,BERT 多用于微調場景。因為微調必須在開源模型的基礎上,GPT 僅開源到 GPT2 的系列。且相同模型參數量下 BERT 在特定場景的效果往往高于 GPT,微調需要調整全部的模型參數,所以從性價比而言,BERT 比 GPT 更適合微調。

而 GPT 目前擁有 ChatGPT 這種面向廣大人民群眾的應用,使用簡單。API 的調用也尤其方便。所以若是僅使用 LLM,則 ChatGPT 顯然更有優勢。

ChatGPT Prompt

Sui基金會舉辦的Sui Builder House香港站活動已收官:金色財經報道,由Sui基金會舉辦的Sui Builder House香港站活動已收官,為期三天,其中最后一場活動Sui Demo Day旨在為Sui生態中的新老項目提供展示項目的平臺,共吸引了超過40個團隊報名參賽。本次Demo Day分為NFT和游戲、基礎設施和開發工具、DID&治理和社交、DeFi和支付四個主要賽道。[2023/4/17 14:07:36]

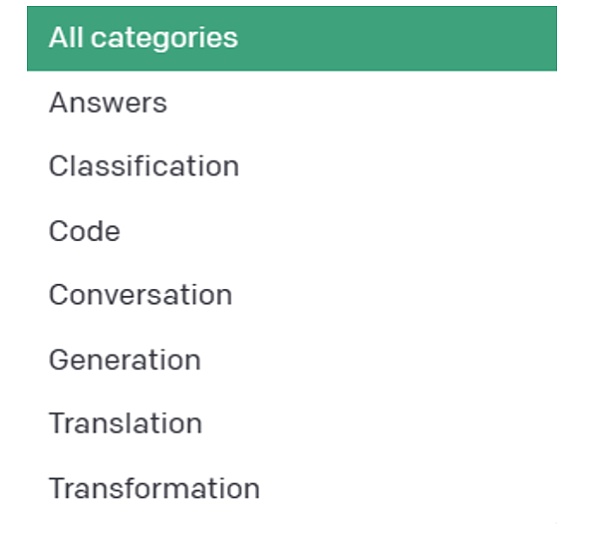

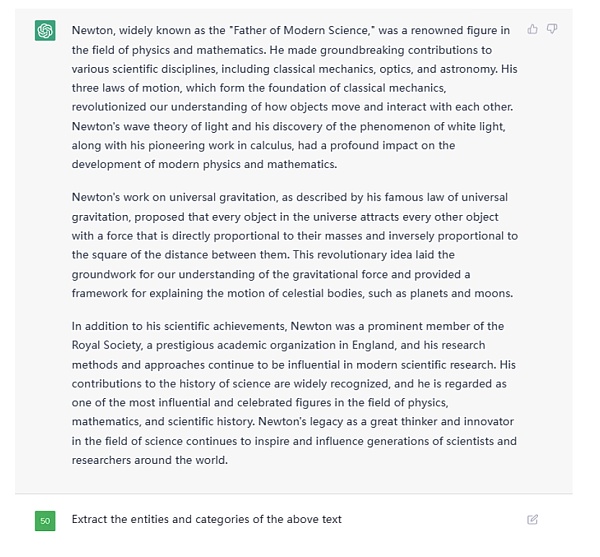

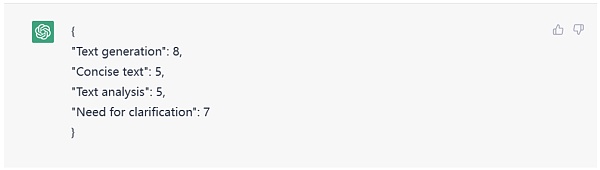

下圖是 OpenAI 官方提出對于 ChatGPT 的 prompt 用法大類。

Figure 1. Prompt Categories by OpenAI

每種類別有很多具體的范例。如下圖所示:

Figure 2. Prompt Categories Examples by OpenAI

除此以外,我們在此提出一些略微高級的用法。

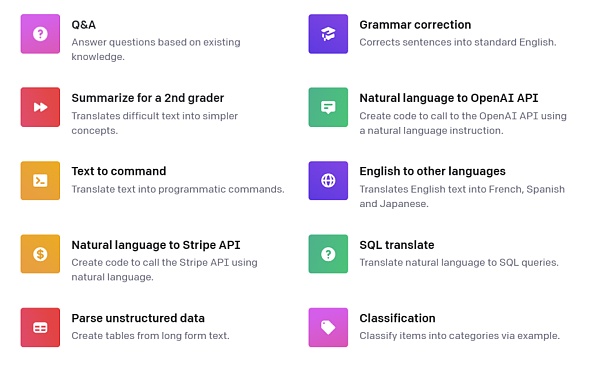

高級分類

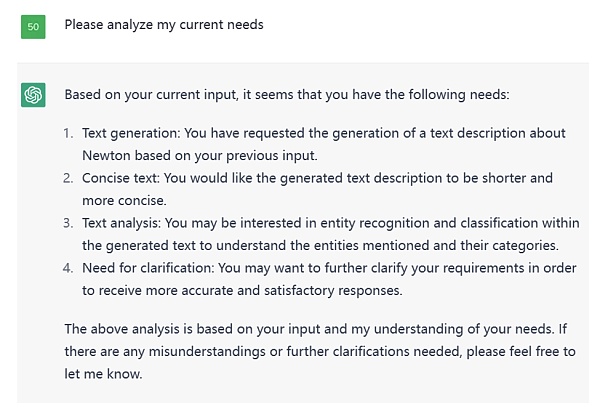

這是一個意圖識別的例子,本質上也是分類任務,我們指定了類別,讓 ChatGPT 判斷用戶的意圖在這

Figure 3. Prompt Examples

BNBChain Builder Grant公布2月份獲勝項目為Frank lin DAO和identity.com:3月21日消息,BNB Chain公布BNBChain Builder Grant計劃2月份獲勝項目,分別為Franklin DAO和identity.com。其中,Franklin DAO團隊由該領域各種DeFi協議和項目的代表以及專注于開發、研究和投資的委員會組成,該團隊計劃為其成員提供有趣的教育體驗。Identity.com是一個身份驗證非營利組織,提供開源、去中心化的生態系統,其網關協議使經過驗證的信息能夠以合規和安全的方式在鏈上訪問。

據悉,BNBChain通過BNBChainBuilderGrant捐贈計劃每月投入最高50萬美元定期支持潛力項目。[2023/3/21 13:16:47]

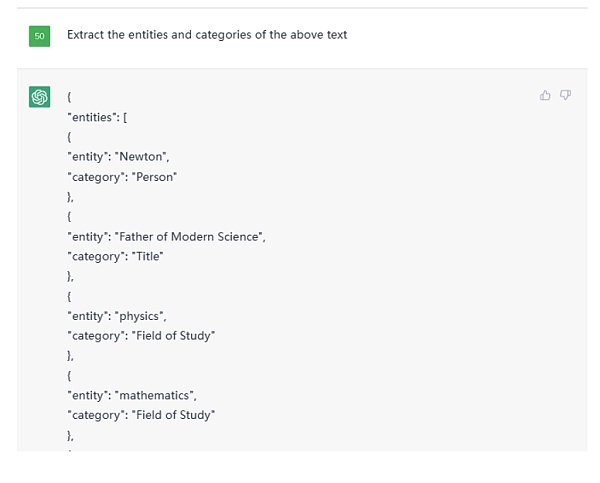

實體識別與關系抽取

利用 ChatGPT 做實體識別與關系抽取輕而易舉,例如給定一篇文本后,這么像它提問。

Figure 4. Example Text Given to ChatGPT

這是部分結果截圖:

Figure 5. Partial Output from given Text on ChatGPT

之后可以追問給他們的關系,例如:

Base 公布“Build on Base”賞金獲勝方為 Decent AI、Rhinestone 和 Inheritable:3月21日消息,Coinbase Layer 2 網絡 Base 公布 ETHDenver BUIDLathon 的“Build on Base” 1.5 萬 USDC 賞金獲勝方,包括 Decent AI、Rhinestone 和 Inheritable。

其中,Decent AI 創建了一個去中心化的市場,基于相互激勵運行 AI 模型。Rhinestone 是一個使用(修改的)Diamond Proxies(ERC-2535)的帳戶抽象(ERC-4337)的模塊化實現。Inheritable 是一種用于安全、去中心化繼承的 Web3 遺囑解決方案,錨定在 Base 上并由 Weavechain 提供支持。[2023/3/21 13:16:46]

Figure 6.Asking relationship on ChatGPT

這樣,一個大型的知識圖譜便可輕松建立。

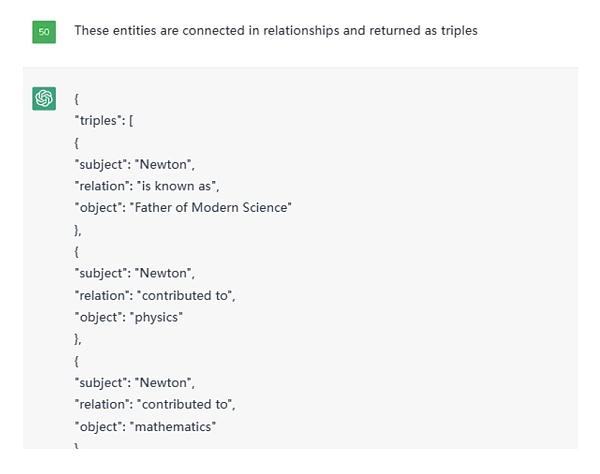

分析任務

如下圖所示,我對 ChatGPT 提出了分析我目前需求的問題。

Figure 7. Result for needs request on ChatGPT

甚至還能讓它給定分數。

Figure 8. Scoring to evaluate the identified needs

LBank即將上線ANT和BUIDL交易:據悉,LBank將于2020年7月30日18:30(UTC+8)上線ANT/USDT、BUIDL/USDT交易對。并于7月30日18:00開啟充值,31日開啟提現。

為慶祝此次上線,LBank將于7月31日16:30 啟動針對ANT、BUIDL的站內流動性挖礦活動。用戶通過在指定交易對盤口的前10檔掛單來獲得獎勵系數,并在隔日瓜分200枚 ANT,每日一輪,連續7天。更多詳情請關注LBank官網公告。[2020/7/30]

除此以外還有數不勝數的方式,在此不一一列舉。

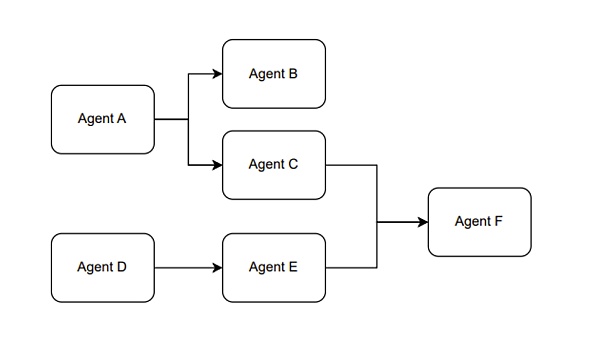

組合Agent

另外,我們在使用 ChatGPT 的 API 時,可以將不同的 prompt 模板產生多次調用產生組合使用的效果。我愿稱這種使用方式叫做,組合 Agent。例如 Figure 1 展示的是一個大概的思路。

Figure 9. The Paradigm of the Combination Agent

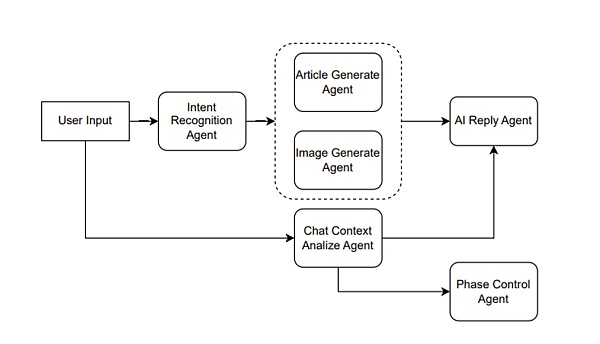

具體說來,例如是一個輔助創作文章的產品。則可以這么設計,如 Figure 10 所示。

Figure 10. Agent combination for assisting in creation

假設用戶輸入一個請求,說“幫我寫一篇倫敦游記”, 那么 Intent Recognition Agent 首先做一個意圖識別,意圖識別也就是利用 ChatGPT 做一次分類任務。假設識別出用戶的意圖是文章生成,則接著調用 Article Generate Agent。

動態 | 日本BUIDL公司成為數字證券平臺Securitize全資子公司:據Crypto.Watch消息,日本BUIDL公司12月6日宣布,已與美國數字證券平臺Securitize建立了全面的資本聯盟。BUIDL將成為Securitize的全資子公司,并將繼續在日本發展區塊鏈業務咨詢和商業化。BUIDL還宣布將擴大其在日本的數字證券業務。[2019/12/6]

另一方面,用戶當前的輸入與歷史的輸入可以組成一個上下文,輸入給 Chat Context Analyze Agent。當前例子中,這個 agent 分析出的結果傳入后面的 AI Reply Agent 和 Phase Control Agent的。

AI Reply Agent 就是用來生成 AI 回復用戶的語句,假設我們的產品前端并不只有一個文章,另一個敵方還有一個框用來顯示 AI 引導用戶創作文章的語句,則這個 AI Reply Agent 就是用來干這個事情。將上下文的分析與文章一同提交給 ChatGPT,讓其根據分析結果結合文章生成一個合適的回復。例如通過分析發現用戶只是在通過聊天調整文章內容,而不知道 AI 還能控制文章的藝術意境,則可以回復用戶你可以嘗試著對我說“調整文章的藝術意境為非現實主義風格”。

Phase Control Agent 則是用來管理用戶的階段,對于 ChatGPT 而言也可以是一個分類任務,例如階段分為[文章主旨,文章風格,文章模板,文章意境]等等。例如 AI 判斷可以進行文章模板的制作了,前端可以產生幾個模板選擇的按鈕。

使用不同的 Agent 來處理用戶輸入的不同任務,包括意圖識別、Chat Context 分析、AI 回復生成和階段控制,從而協同工作,為用戶生成一篇倫敦游記的文章,提供不同方面的幫助和引導,例如調整文章的藝術意境、選擇文章模板等。這樣可以通過多個 Agent 的協作,使用戶獲得更加個性化和滿意的文章生成體驗。

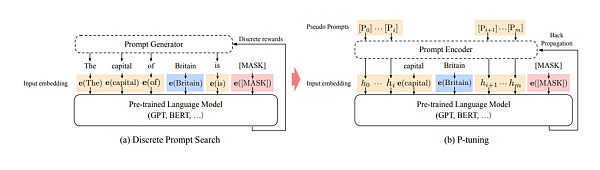

Prompt 微調

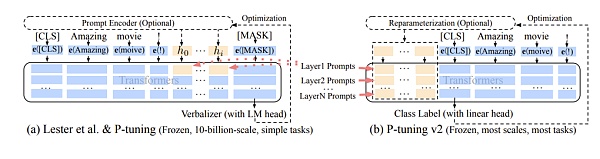

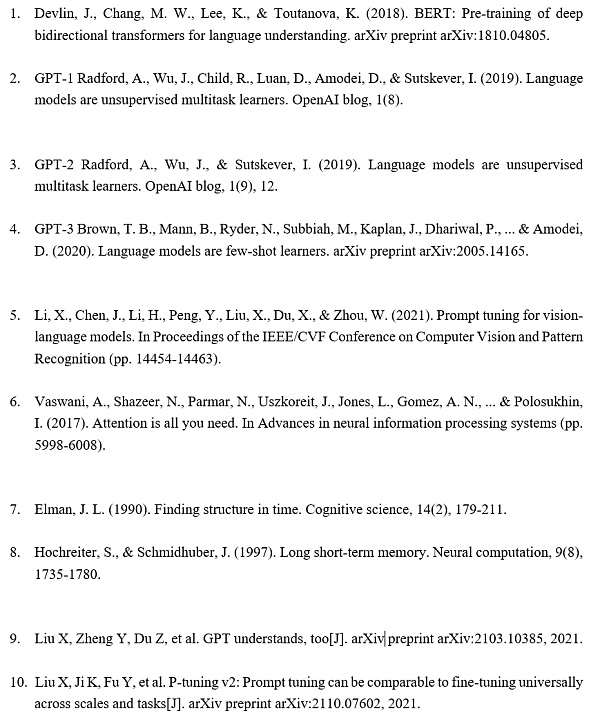

LLM 雖然很厲害,但離統治人類的 AI 還相差甚遠。眼下有個最直觀的痛點就是 LLM 的模型參數太多,基于 LLM 的模型微調變得成本巨大。例如 GPT-3 模型的參數量級達到了 175 Billion ,只有行業大頭才有這種財力可以微調 LLM 模型,對于小而精的公司而言該怎么辦呢。無需擔心,算法科學家們為我們創新了一個叫做 prompt tuning 的概念。

Prompt tuning 簡單理解就是針對prompt進行微調操作,區別于傳統的 fine-tuning,優勢在于更快捷, prompt tuning 僅需微調 prompt 相關的參數從而去逼近 fine-tuning 的效果。

Figure 11. Prompt learning

什么是 prompt 相關的參數,如圖所示,prompt tuning 是將 prompt 從一些的自然語言文本設定成了由數字組成的序列向量。本身 AI 也會將文本從預訓練模型中提取向量從而進行后續的計算,只是在模型迭代過程中,這些向量并不會跟著迭代,因為這些向量于文本綁定住了。但是后來發現這些向量即便跟著迭代也無妨,雖然對于人類而言這些向量迭代更新后在物理世界已經找不到對應的自然語言文本可以表述出意思。但對于 AI 來講,文本反而無意義,prompt 向量隨著訓練會將 prompt 變得越來越符合業務場景。

假設一句 prompt 由 20 個單詞組成,按照 GPT3 的設定每個單詞映射的向量維度是12288,20個單詞便是245760,理論上需要訓練的參數只有245760個,相比175 billion 的量級,245760這個數字可以忽略不計,當然也會增加一些額外的輔助參數,但同樣其數量也可忽略不計。

問題來了,這么少的參數真的能逼近 fine tuning 的效果嗎,當然還是有一定的局限性。如下圖所示,藍色部分代表初版的 prompt tuning, 可以發現 prompt tuning 僅有在模型參數量級達到一定程度是才有效果。雖然這可以解決大多數的場景,但在某些具體垂直領域的應用場景下則未必有用。因為垂直領域的微調往往不需要綜合的 LLM 預訓練模型,僅需垂直領域的 LLM 模型即可,但是相對的,模型參數不會那么大。所以隨著發展,改版后的 prompt tuning 效果可以完全取代 fine-tuning。下圖中的黃色部分展示的就是 prompt tuning v2 也就是第二版本的 prompt tuning 的效果。

Figure 12. Prompt learning parameters

V2 的改進是將原本僅在最初層輸入的連續 prompt 向量,改為在模型傳遞時每一個神經網絡層前均輸入連續 prompt 向量,如下圖所示。

Figure 13. Prompt learning v2

還是以 GPT3 模型為例,GPT3 總從有96層網絡,假設 prompt 由20個單詞組成,每個單詞映射的向量維度是12288,則所需要訓練的參數量 = 96 * 20 * 12288 =23592960。是175 billion 的萬分之1.35。這個數字雖不足以忽略不計,但相對而言也非常小。

未來可能會有 prompt tuning v3, v4 等問世,甚至我們可以自己加一些創新改進 prompt tuning,例如加入長短期記憶網絡的設定。(因為原版的 prompt tuning v2 就像是一個大型的 RNN, 我們可以像改進RNN 一般去改進prompt tuning v2)。總之就目前而言,prompt tuning 使得微調 LLM 變得可行,未來一定會有很多垂直領域的優秀模型誕生。

總結

Large Language Models (LLMs) 和 Web3 技術的整合為去中心化金融(DeFi)領域帶來了巨大的創新和發展機遇。通過利用 LLMs 的能力,應用程序可以對大量不同數據源進行全面分析,生成實時的投資機會警報,并根據用戶輸入和先前的交互提供定制建議。LLMs 與區塊鏈技術的結合還使得智能合約的創建成為可能,這些合約可以自主地執行交易并理解自然語言輸入,從而促進無縫和高效的用戶體驗。

這種先進技術的融合有能力徹底改變 DeFi 領域,并開辟出一條為投資者、交易者和參與去中心化生態系統的個體提供新型解決方案的道路。隨著 Web3 技術的日益普及,LLMs 創造復雜且可靠解決方案的潛力也在擴大,這些解決方案提高了去中心化應用程序的功能和可用性。總之,LLMs 與 Web3 技術的整合為 DeFi 領域提供了強大的工具集,提供了有深度的分析、個性化的建議和自動化的交易執行,為該領域的創新和改革提供了廣泛的可能性。

參考文獻

金色薦讀

金色財經 善歐巴

Chainlink預言機

區塊律動BlockBeats

白話區塊鏈

金色早8點

Odaily星球日報

歐科云鏈

MarsBit

深潮TechFlow

Tags:ROMPROOMPMPTPrometheus Tradingbitopro交易所下載Compound Metampt幣發行量

作者:餅干,ChainCatcher自第一個加密貨幣出現以來,單體區塊鏈一直是行業標準,但這種情況正在迅速改變.

1900/1/1 0:00:00撰文:孟鉉濟,Fox Tech 首席科學家;康水躍,Fox Tech CEOLayer1作為一種分布式系統,為了達成共識需要高昂的通訊代價,并且大量的計算也會消耗昂貴的gas.

1900/1/1 0:00:00來源:zkLink 社區加密世界經常被形容為黑暗森林,這是一個充滿機遇,但也危險重重的新大陸。黑客攻擊和程序漏洞時刻威脅著用戶資金安全,更有甚者,詐騙項目卷款跑路的事情也時有發生,大大提高用戶篩.

1900/1/1 0:00:00作者:kenyou 由 Gwei Research 編譯Ordinals NFT 和 BRC-20 代幣的出現.

1900/1/1 0:00:002022 年以來,加密行業數場突如其來的暴雷事件給整個市場帶來了非常嚴重的動蕩,此前快速增長的加密生態也由此轉為衰退.

1900/1/1 0:00:00作者:黑米,白澤研究院 最近,新公鏈 Berachain 完成了 4200 萬美元的融資,Polychain Capital 領投.

1900/1/1 0:00:00